Under migrantprotestene i Los Angeles blir kunstig intelligens brukt til å lage falske videoer og feilaktige bildesøk. Nå advares det mot at teknologien bidrar til å forvirre og polarisere.

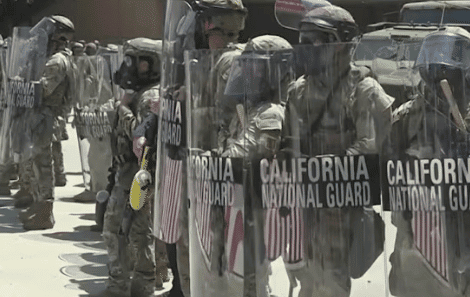

Demonstrasjoner brøt ut i Los Angeles 6. juni etter at over 40 migranter ble arrestert i sentrum av byen av immigrasjonsmyndighetene (ICE). Protestene førte raskt til sammenstøt med politiet og eskalerte ytterligere etter at president Donald Trump 7. juni sendte inn nasjonalgarden – mot Californias guvernør Gavin Newsoms vilje. Dette melder France 24 Observers.

I denne spente situasjonen har kunstig intelligens blitt brukt til å spre villedende innhold på nettet.

Falsk soldatvideo laget med KI

En video publisert 9. juni på TikTok, angivelig fra en soldat i nasjonalgarden ved navn «Bob», fikk over 770 000 visninger. Videoen viser soldaten som smilende forklarer hvordan de gjør seg klare for innsats, og klager senere over å ha blitt truffet av «oljefylte ballonger».

Videoen viste seg å være generert med KI. Merker på uniformen inneholder tegn uten mening, og et trafikklys henger på en umulig måte. I tillegg er politibilen merket med «LAPC» – en forkortelse som ikke finnes, siden Los Angeles-politiet heter LAPD.

Les også: Los Angeles i flammer etter ICE-aksjoner – Trump svarer med 2 000 soldater

Selv om TikTok-kontoen oppgir at den publiserer satire, finnes ingen slik merking i selve videoen. Mange tok derfor innholdet som ekte, og kommenterte med støtte til soldaten – eller kritikk for å skade demonstranter.

Bildestrid mellom guvernør og chatbot

Samtidig delte guvernør Gavin Newsom et bilde av soldater som sover på gulvet, og anklaget Trump for å sende dem uten mat, drivstoff eller innkvartering.

– Hvis noen viser mangel på respekt for troppene våre, er det deg, Donald Trump, skrev Newsom.

Kort tid etter hevdet en bruker at bildet var gammelt og stammer fra Kabul i 2021. Påstanden var basert på et bildesøk gjort av ChatGPT.

Men dette viste seg å være feil. En journalist fra BBC Verify og France 24-teamet undersøkte saken, og kunne spore bildet tilbake til San Francisco Chronicle, som publiserte det 9. juni 2025 – samme dag som Newsom. Bildet var ikke tilgjengelig på nett før denne datoen.

Feilkilden viste seg å være manglende nøyaktighet i KI-verktøy som ChatGPT og Grok, som ga motstridende svar avhengig av tidspunkt for søket.

Ekspertene advarer nå mot at KI kan bidra til å svekke informasjonsgrunnlaget i politisk betente situasjoner.