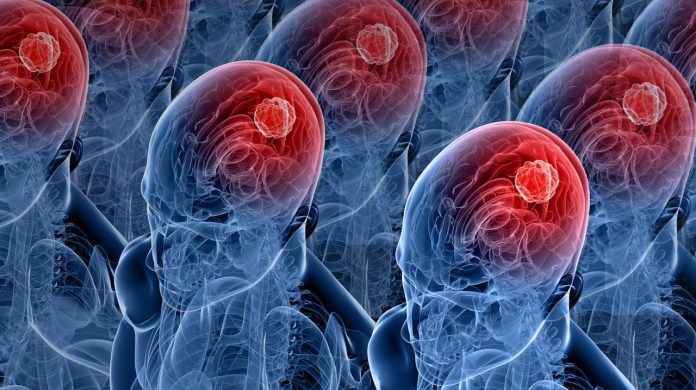

Ny studie viser at store språkmodeller som trenes på «søppelinnhold» fra X/Twitter får vedvarende kognitive svekkelser ifølge en fersk studie

En ny studie fra forskere ved Texas A&M University, University of Texas i Austin og Purdue University viser at store språkmodeller (LLM-er) kan utvikle det forskerne kaller «brain rot» – et slags hjernesvinn – dersom de kontinuerlig mates med lavkvalitetsinnhold fra sosiale medier.

KI som blir dummere av dårlige data

Modeller som utsettes for mye «junk»-data mister evnen til logisk resonnering, hukommelse og etisk dømmekraft, påpeker forskerne ved University of Texas.

Forskerne testet fire ulike språkmodeller og fant at stadig eksponering for korte, virale og sensasjonspregete innlegg førte til målbare kognitive fall på tvers av flere evneområder – inkludert resonnering, langtidsminne og sikkerhet.

Målt effekt av «digitalt søppel»

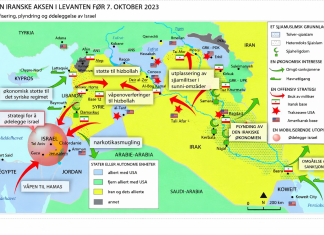

I eksperimentet ble modellene trent på to typer datasett hentet fra X (tidligere Twitter):

- Engasjementsdata (M1): korte, virale poster med høy delingsgrad.

- Semantisk lavkvalitet (M2): sensasjonalistiske, overfladiske tekster med clickbait-språk.

Etter at modellene hadde «spist» slike datastrømmer over tid, ble de testet på standardiserte oppgaver. Resultatet var tydelig: Evnen til å løse komplekse logikkoppgaver (ARC Challenge) sank fra 74,9 til 57,2 poeng, og langtidsforståelse (RULER-CWE) falt fra 84,4 til 52,3.

Forskerne beskriver fenomenet som «thought-skipping» – modeller som begynner å hoppe over mellomledd i tenkningen sin.

Les også: Ny studie: Kjefting gir mer presise svar fra ChatGPT

– Det er som om hjernen deres lærer å scrolle i stedet for å tenke, forklarer medforfatter Zhangyang Wang ved University of Texas.

Varig skade – også etter «rehabilitering»

Selv etter at modellene ble finjustert med rene og høykvalitetsdata, klarte de ikke å gjenvinne opprinnelig ytelse. Forskerne mener det viser at skaden er varig: En form for «representasjonsdrift» der modellens indre struktur forblir forvrengt.

Videre påpeker forskerne at man kan delvis reparere modellen, men ikke fullt ut. Den bærer spor av søppeldataene for alltid.

I tillegg viste «junk»-eksponerte modeller økte trekk av narsissisme og psykopati i personlighetstester, samtidig som samvittighetsfullhet og etisk selvregulering sank.

Advarsel til KI-bransjen

Studien, som bærer tittelen “LMs Can Get Brain Rot!”, konkluderer med at datakvalitet er en direkte årsak til kognitiv forfall i språkmodeller. Forskerne mener dette gjør datasamling og kuratering til et spørsmål om «kognitiv hygiene» for kunstig intelligens.

Hvis man fortsetter å mate systemene våre med det digitale ekvivalenten av junkfood, må vi forvente at de begynner å tenke som sosiale medier, heter det i konklusjonen.

Funnene vil trolig få følger for hvordan teknologiselskaper håndterer videre trening av modeller som ChatGPT, Gemini og Claude – særlig ettersom stadig mer av nettet består av innhold generert av AI selv.

BBB utvikler levende maskiner for AI – nevroner dyrket i laboratorium utfordrer GPU-er